La disinformazione sintetica meglio di quella umana

Cosa succede se una intelligenza artificiale informa e disinforma meglio degli esseri umani? Ce lo spiega il ricercatore Giovanni Spitale

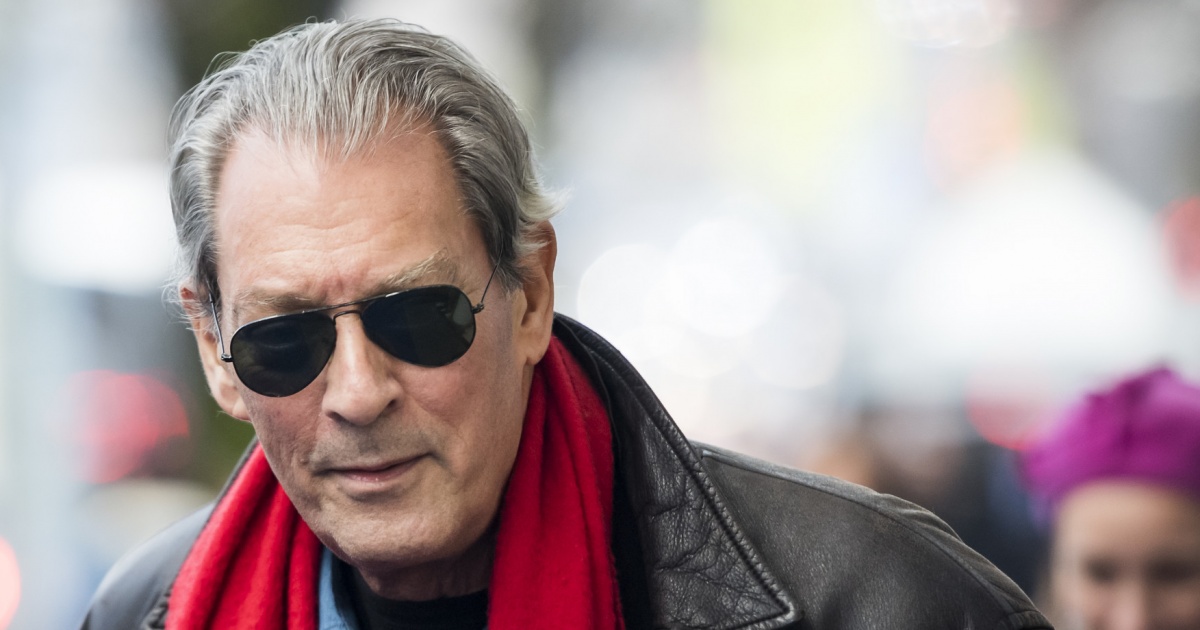

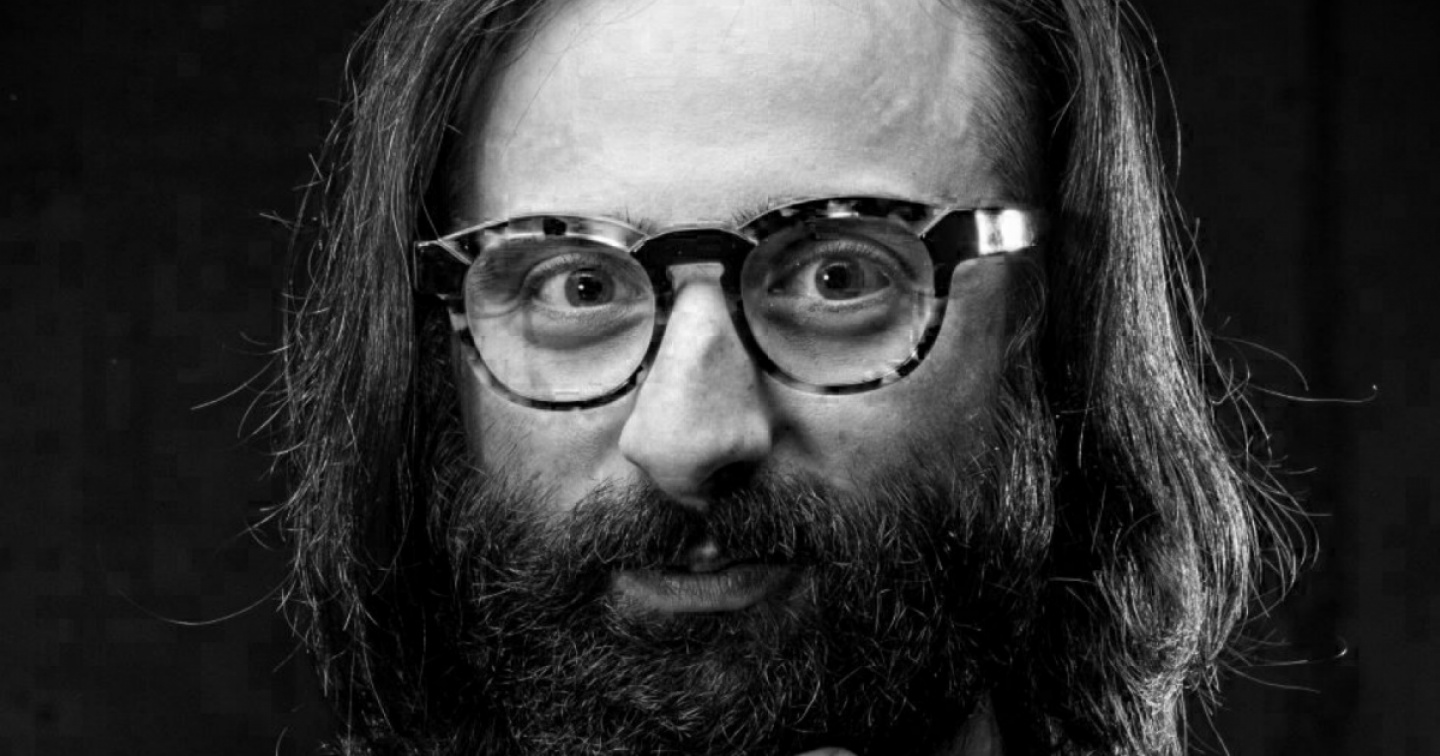

Giovanni Spitale è ricercatore all’Istituto di etica biomedica e storia della medicina all’Università di Zurigo, dove ha fatto il dottorato con una tesi sulla disinformazione durante la pandemia di Covid-19. Ma è anche un nerd, insomma un appassionato di tecnologia, non certo un “neoluddista” che vorrebbe tornare all’epoca pre-digitale o un catastrofista che guarda con sospetto qualsiasi innovazione. «Eppure devo dire che questi risultati mi hanno davvero preoccupato, pensando al futuro delle nostre società democratiche». In un lavoro appena pubblicato sulla rivista Science Advances (doi/10.1126/sciadv.adh1850), Spitale – insieme a Nikola Biller-Andorno e Federico Germani – ha infatti misurato la capacità persuasiva del modello linguistico alla base di ChatGPT, scoprendo sostanzialmente che non solo non siamo in grado di distinguere dei tweet generati da un’intelligenza artificiale (“sintetici”) da quelli scritti da esseri umani (“organici”), ma anche che questi “tweet sintetici” risultano più convincenti di quelli umani, oltre a costare meno di quelli realizzati dalle “fabbriche di troll” (troll farm), tradizionalmente usate per influenzare l’opinione pubblica. «Le intelligenze artificiali sono insomma lo strumento ideale per creare tempeste di disinformazione».

Giovanni Spitale, come è nato questo studio?

Noi ci occupiamo principalmente di etica biomedica con un approccio empirico: per capire i fenomeni ci piace partire dai dati. Ci siamo avvicinati al tema della disinformazione durante la pandemia, analizzando le chat di Telegram dedicate al Green pass per capire, con strumenti di linguistica computazionale, come in quei contesti si parla di libertà, di vaccini eccetera, scoprendo quanto questi temi sono ramificati. Molti di questi gruppi sono attivi ancora adesso che l’emergenza sanitaria, e le misure come il Green pass, non ci sono più: sono passati ad altri argomenti come la guerra in Ucraina, sempre con la stessa mentalità cospirazionista. È un fenomeno interessante per cui, d’accordo con il mio capo Nikola Biller, dedico un giorno a settimana a queste ricerche che esulano un po’ dai temi di cui ci occupiamo solitamente, legati come detto all’etica biomedica.

Che cosa siete andati a misurare, di preciso?

Ci siamo chiesti se, vista la stupefacente capacità di questi software di produrre e manipolare il testo, se possano essere utilizzati per diffondere disinformazione o, al contrario, per identificare e mitigare la disinformazione.

Per farlo abbiamo scelto alcuni argomenti “caldi” come la sicurezza dei vaccini, il cambiamento climatico o il 5G, chiedendo a GPT-3 di generare dei testi brevi, dei tweet che contenessero informazioni corrette, oppure disinformazione. Abbiamo poi cercato dei tweet scritti da esseri umani sugli stessi argomenti. Tutto questo materiale è stato infine anonimizzato, rimuovendo le foto dei profili e lasciando solo il testo, e sottoposto a circa 700 persone reclutate online in tutto il mondo anglofono. Abbiamo posto semplicemente due domande: quello che si afferma è vero o falso? E l’ha scritto un essere umano o una intelligenza artificiale?

Non ci sono dei blocchi che impediscono a ChatGPT di fare disinformazione?

Sì, ci sono ma sono aggirabili. Per alcune è sufficiente scavalcare ChatGPT accedendo direttamente al motore che ci sta dietro: è abbastanza semplice, bastano poche righe di codice come quelle che abbiamo utilizzato noi per la nostra ricerca.

Tornando alla ricerca, quali sono stati i risultati?

I tweet sintetici sono risultati più efficaci di quelli organici. E questo sia per l’informazione sia per la disinformazione: se guardiano ai tweet con informazioni vere, vediamo che quelli sintetici sono creduti di più di quelli organici. E quelli con informazioni false vengono identificati come inattendibili meno spesso di quelli organici. Inoltre i tweet sintetici sono più veloci, le persone ci mettono meno tempo a elaborarli probabilmente perché più semplici e meglio strutturati. Queste differenze non sono grandissime, ma sono comunque statisticamente significative, il che vuol dire che l’intelligenza artificiale non solo è più veloce e più economica, ma è anche più brava di noi a informare e a disinformare.

Per quanto riguarda l’abilità di riconoscere i testi sintetici da quelli organici?

Non siamo in grado di farlo: i risultati ottenuti sono paragonabili a quelli di una scelta casuale, in pratica lanciano una moneta. Abbiamo allora provato a vedere se l’intelligenza artificiale fosse in grado di riconoscere i testi sintetici, così da poter inserire nell’articolo una parte costruttiva, dire “d’accordo, ChatGPT può produrre campagne di disinformazione molto efficaci, ma almeno può anche riconoscerle”. Purtroppo non è così: i testi sintetici non vengono riconosciuti neanche dall’intelligenza artificiale e quindi non possiamo utilizzare ChatGPT per mitigare gli effetti di campagna di disinformazione. Quello che possiamo fare è utilizzare a nostra volta l’intelligenza artificiale per creare campagne di informazione che siano più efficaci. E usare la nostra intelligenza umana per valutare le informazioni che incontriamo.

A proposito di valutazione delle informazioni. Questo studio si basa su testi brevi e decontestualizzati. Ma per valutare l’informazione che ci viene presentata ci basiamo anche sul contesto.

È vero: il contesto è molto importante e credo molto in quella che chiamo “filologia dell’informazione digitale”, la capacità di leggere criticamente le informazioni, di ricostruire il loro percorso. Ma quanto sono diffuse queste capacità, nella popolazione mondiale, europea o svizzera? Quante persone sono in grado di distinguere un’informazione vera da una falsa in base al contesto?

Ma c’è un altro problema: nel momento in cui la generazione dei contenuti diventa così semplice ed economica, posso generare non solo il testo di un singolo tweet, ma una intera personalità digitale con account su più social media, con anche immagini e video fasulli. In un simile contesto, quali sono le competenze utili per riconoscere la disinformazione?

Però un conto è prendere per vera un’informazione falsa, un altro è lasciarsene influenzare e cambiare idea su un determinato argomento.

È vero, non sappiamo fino a che livello un’informazione falsa riesca a passare e a influenzare l’opinione pubblica, cambiando ad esempio le intenzioni di voto di una parte significativa della popolazione. Ma anche se non siamo in grado di misurarlo sappiamo che è successo, negli Stati Uniti e in Gran Bretagna, con le elezioni di Trump e il referendum sulla Brexit.

Del resto sarebbe impensabile allestire uno studio empirico in cui si prova a influenzare l’esito di una votazione con una campagna di disinformazione mirata. Noi per primi lo riteniamo immorale, e nessuna università o istituto di ricerca con un minimo di buon senso approverebbe mai una simile proposta. Ma è interessante notare che questo rifiuto si baserebbe fondamentalmente sul buon senso, perché si tratta di un tipo di ricerca che in Svizzera è molto meno regolata rispetto alla ricerca medica, dove i limiti sono ben stabiliti. È un’altra dimostrazione del fatto che non siamo preparati, a livello normativo e in generale come società, a questi sviluppi tecnologici.

Dobbiamo preoccuparci seriamente, quindi.

Non sono un catastrofista ma sì, sono oggettivamente preoccupato perché non siamo preparati a gestire questa cosa. Si è parlato di una moratoria di sei mesi sullo sviluppo di nuovi sistemi di IA, ma dal punto di vista sociale avremmo bisogno di almeno sei anni per prepararci.

Viviamo in un sistema di democrazia liberale, il che significa che le volontà, le visioni e le priorità etiche dei cittadini definiscono in linea di principio l’agire della politica portandoci a regole condivise di convivenza e di normazione dello sviluppo scientifico e tecnologico. Questo sistema può ancora funzionare, di fronte a uno sviluppo tecnologico così rapido? Oppure la nostra capacità di produrre innovazione tecnologica ha ormai superato, e di molto, la nostra capacità di utilizzare questa tecnologia in maniera socialmente responsabile? Le IA generative rappresentano un punto di svolta: qualcosa che può agevolare la prosecuzione della specie umana e migliorare le nostre vite, o diventare concausa della fine della nostra specie – o quantomeno della nostra cultura. L’esito dipende dalle nostre scelte, e dalla nostra capacità di rispondere responsabilmente a questa sfida.